Open WebUI インストール2025/02/13 |

|

LLM を WebUI から実行可能な Open WebUI をインストールします。 Open WebUI は pip3 でもインストールできますが、当例ではコンテナーで起動します。 |

|

| [1] | |

| [2] | |

| [3] | Open WebUI のコンテナーイメージを Pull して起動します。 |

|

[root@dlp ~]# podman pull ghcr.io/open-webui/open-webui:main [root@dlp ~]# podman images REPOSITORY TAG IMAGE ID CREATED SIZE ghcr.io/open-webui/open-webui main a088eea70396 7 days ago 4.33 GB

[root@dlp ~]#

[root@dlp ~]# podman run -d -p 3000:8080 --add-host=host.containers.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

podman ps CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES 7983190066ff ghcr.io/open-webui/open-webui:main bash start.sh 4 seconds ago Up 4 seconds 0.0.0.0:3000->8080/tcp open-webui |

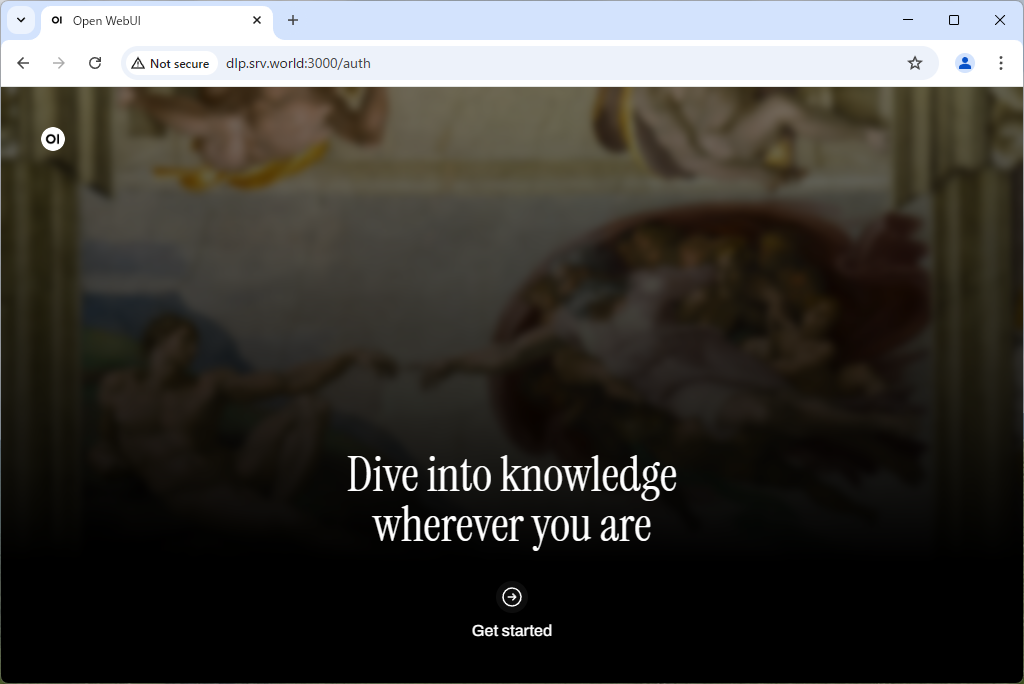

| [4] | 任意のクライアントコンピューターで Web ブラウザーを起動し、アプリケーションにアクセスして動作確認します。 アクセスすると以下の画面になるので、[開始する] をクリックします。 |

|

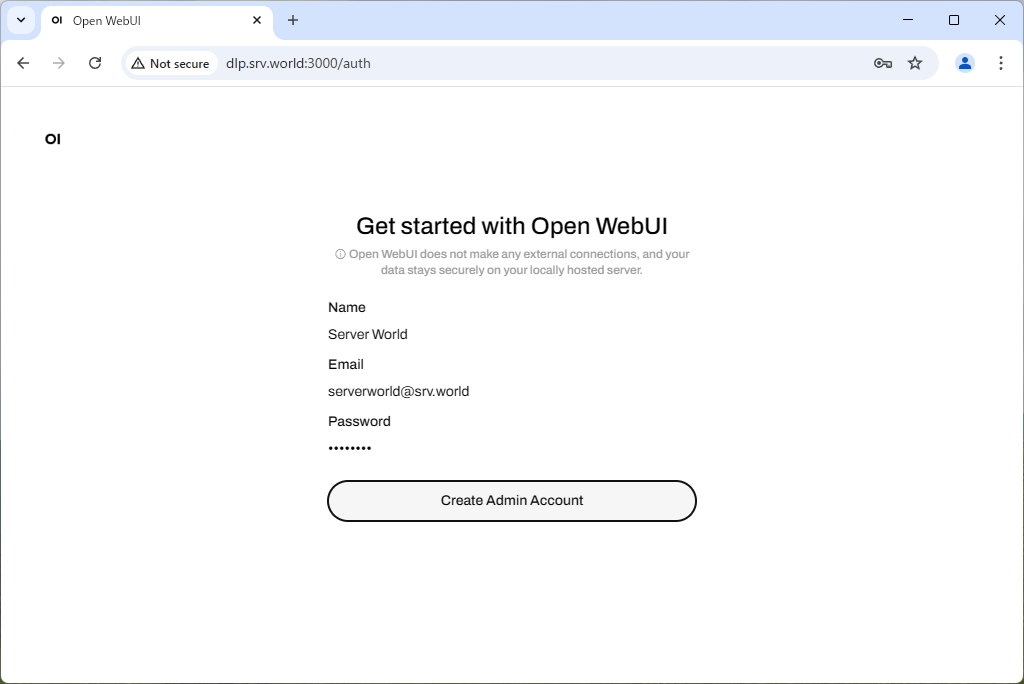

| [5] | 初回アクセス時は管理者アカウントの作成が必要です。必要な項目を入力して [Create Admin Account] をクリックします。 |

|

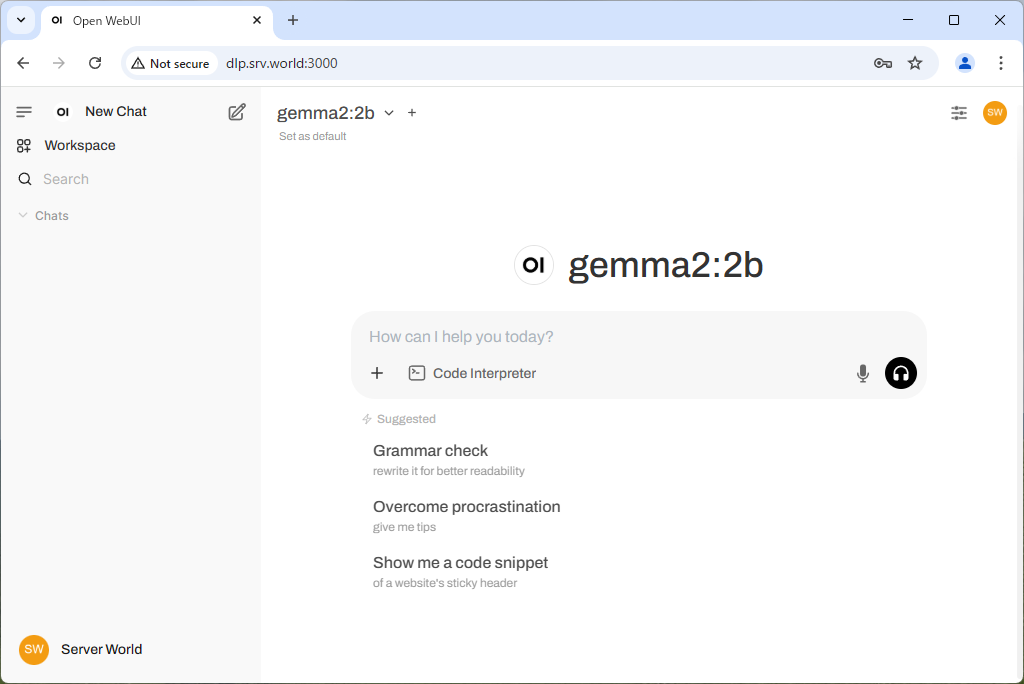

| [6] | 管理者アカウントが作成されると、Open WebUI のデフォルトページが表示されます。 |

|

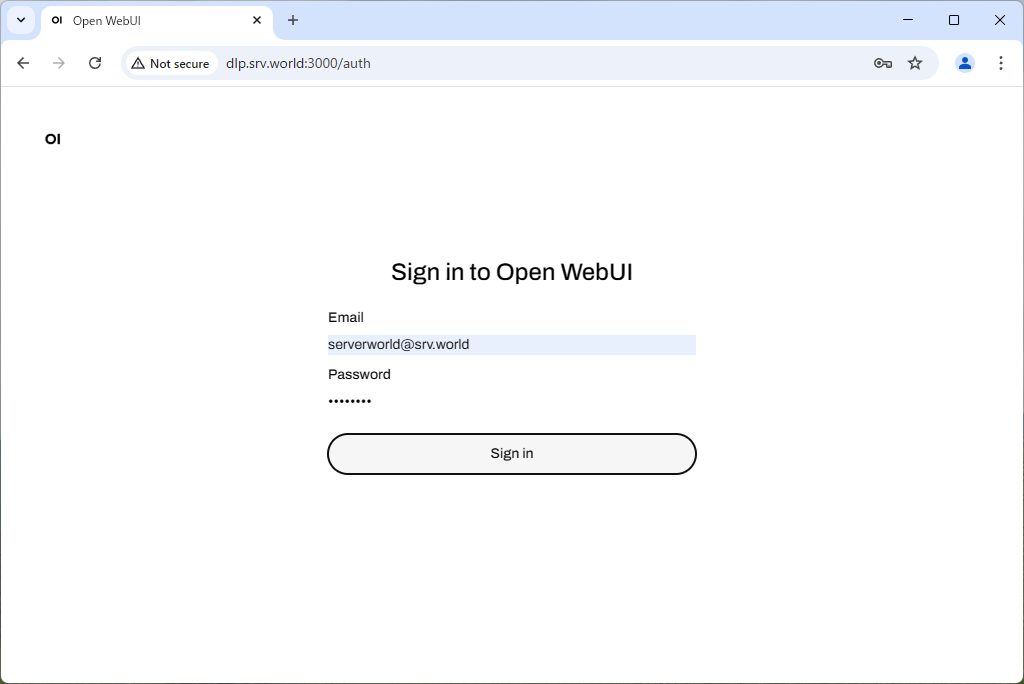

| [7] | 次回からは、登録したメールアドレスとパスワードでログイン可能です。 |

|

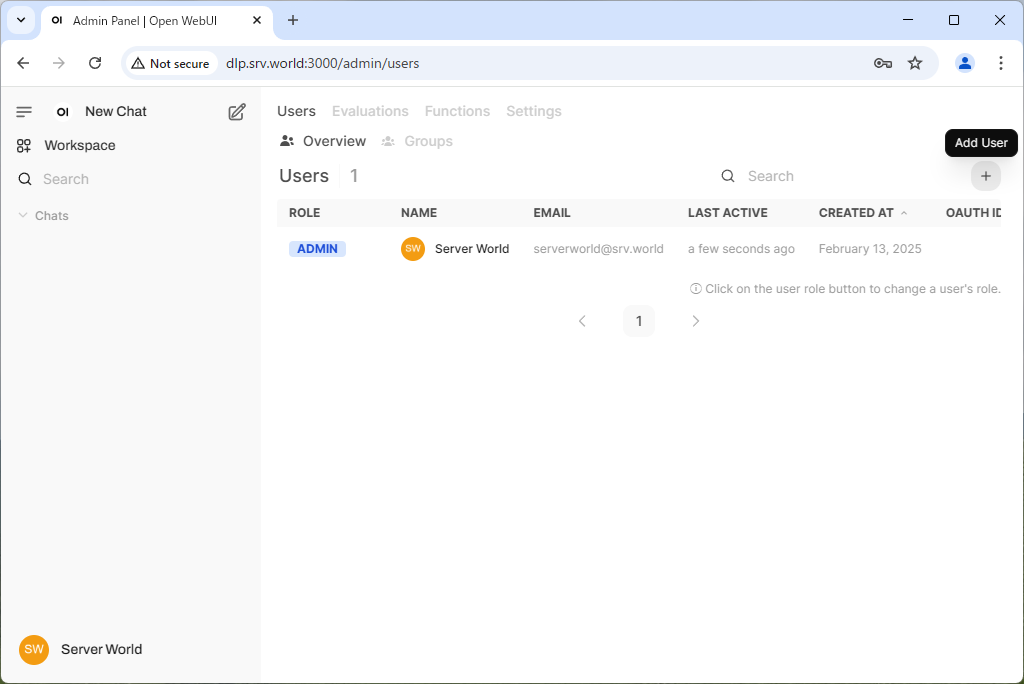

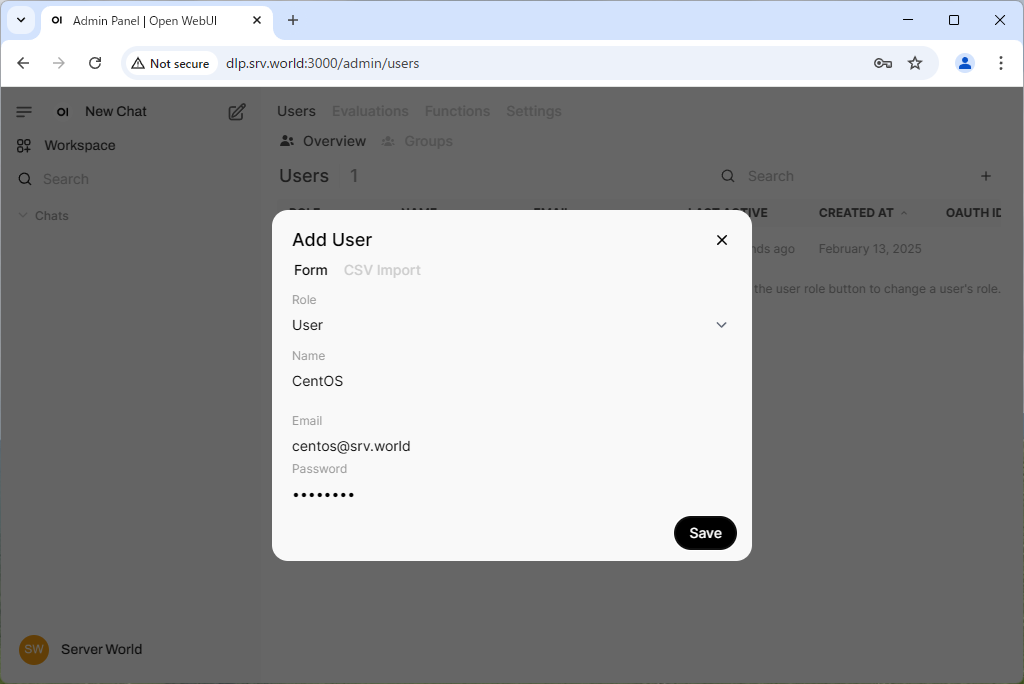

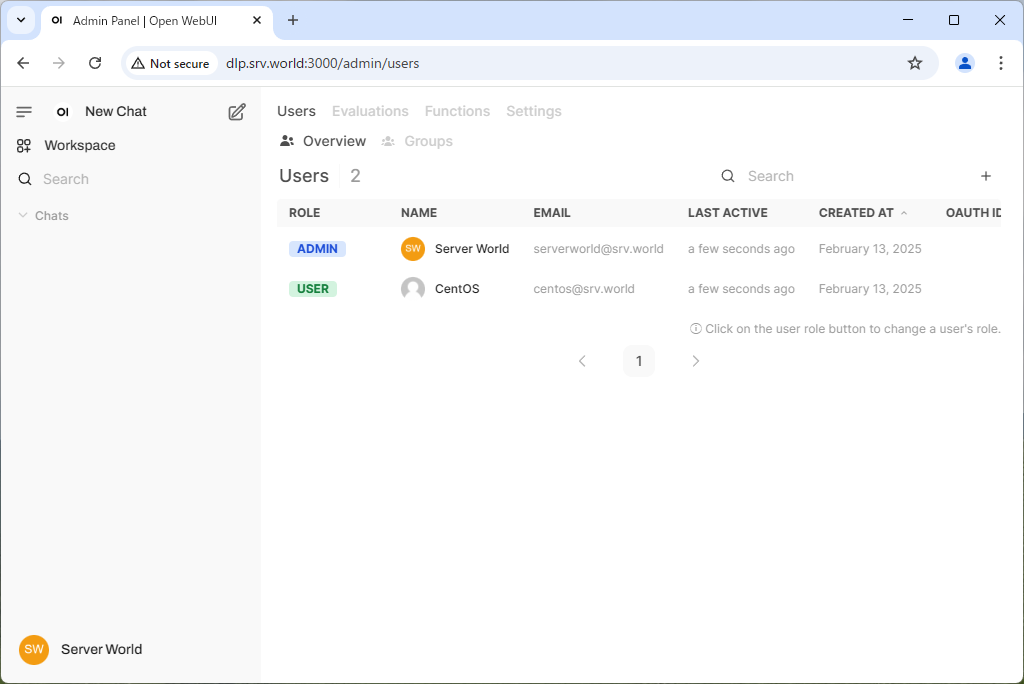

| [8] | 2 人目以降のユーザーは、管理者アカウントの管理画面からユーザー登録することで追加できます。 |

|

|

|

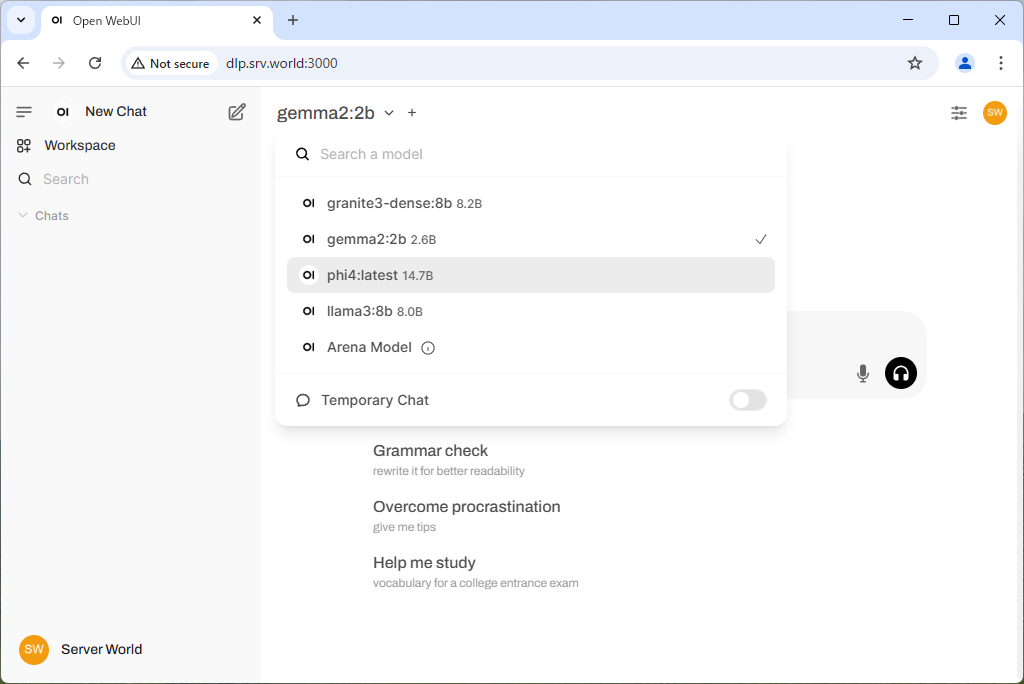

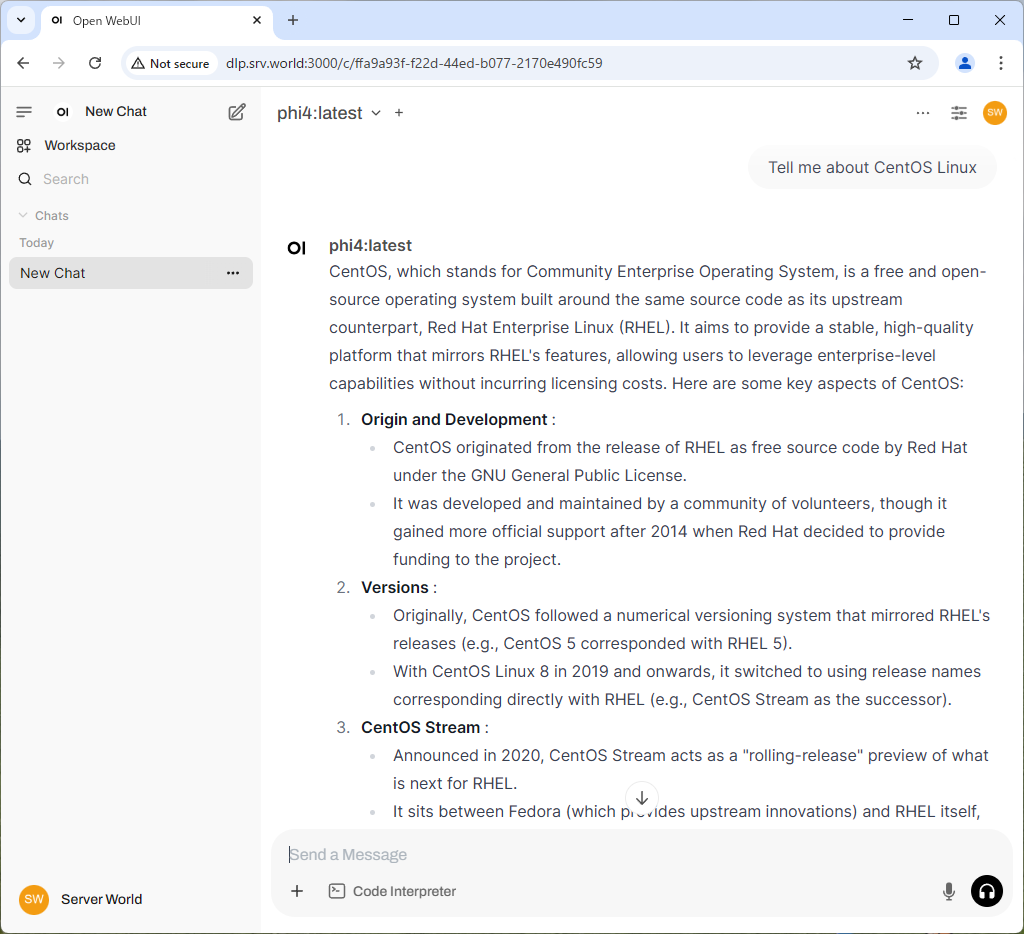

| [9] | Chat を利用するには、上部メニューから Ollama に読み込ませたモデルを選択して、下段にメッセージを入力すると、返答が返ってきます。 |

|

|

関連コンテンツ